Observer le processus de constitution d’une notation musicale en direct

L’électroacoustique, en naissant pratiquement sous nos yeux au milieu du XXe siècle, nous offre la chance d’observer le processus de constitution d’une notation musicale, en direct.

Depuis l’arrivée de l’électricité dans l’art musical — le Telharmonium 2 de l’américain Thaddeus Cahill date de 1906 1[1. Le premier instrument électrique connu date de 1759; il s’agit du clavecin électrique de Jean-Baptiste Thillaie de la Borde (1730–1777). Mais le dynamophone ou Telharmonium de l’américain Thaddeus Cahill (1867–1934) est véritablement le premier à offrir des sons entièrement générés par l’électricité, à partir de 1896, grâce à l’usage du dispositif de la Roue phonique, un système électromécanique. À cette époque, l’enceinte acoustique n’existe pas encore, la musique jouée sur le Dynamophone est diffusée par le réseau téléphonique de la Ville de New York. L’orgue Hammond fondé sur le principe du dynamophone apparaît plus tard, en 1935.], l’enregistrement date de la fin du XIXe siècle 2[2. En 1877, Thomas Edison met au point un système d’enregistrement sur cylindre avec une aiguille, ainsi que le microphone à charbon. En 1885, Graham Bell met au point le phonographe : enregistrement sur disques souples en gravure directe. En 2008, on découvre que le Français Edouard-Léon Scott de Martinville avait inventé le phonautographe dès1860 (donc bien avant Edison).] — on assiste à un élargissement spectaculaire de toutes les notions musicales de base considérées longtemps comme immuables, au moins depuis 300 ans pour le cercle occidental. Le XXe siècle voit ainsi apparaître un nouveau type de notation musicale dû à l’émergence d’un nouvel instrumentarium et de nouveaux types de musique associés. Aujourd’hui, on ne peut plus se contenter d’écrire simplement le nom d’un instrument de l’orchestre classique en début de ligne sur la partition, comme violon, flûte ou piano, tant les critères sonores — notamment de variation de timbre — se sont élargis avec les nouveaux appareils et les nouvelles techniques. Il en est de même pour les nuances et les hauteurs de sons qui peuvent se décliner et s’exécuter dans le plus grand raffinement, à toutes les échelles, jusqu’aux seuils de perceptions de notre appareil auditif; sans parler du travail spécifique sur les mouvements spatiaux, la multiplication des couches sonores et l’extrême complexité des actions rythmiques.

Très vite apparaissent de nombreuses propositions de notations, pour aider à consigner tous les détails de l’interprétation, tous les points de vue d’écoute et toutes les sources sonores employées.

Mais la constitution de ces nouvelles écritures n’est pas tout à fait synchrone avec l’émergence des nouvelles esthétiques musicales — elle la suit avec un retard temporel variable et semble répondre à ses propres lois. En replaçant l’histoire récente des recherches sur la notation symbolique de la musique électroacoustique (EA) dans l’histoire générale de l’émergence de l’écriture, pas seulement musicale, on reconnaîtra différentes étapes qui reviennent de façon cyclique, à l’apparition de chaque nouvelle rupture technologique. La standardisation de ces nouvelles écritures, pouvant alors se concevoir comme une étape ultérieure et le point de départ d’un nouveau type de création.

Répondre à l’élargissement des critères musicaux

Les musiques du XXe siècle, en s’emparant des techniques électroacoustiques ont donné naissance à un nouvel instrumentarium : les prototypes comme le Telharmonium (1906), le Theremin (1917), les Ondes Martenot (1928), le Trautonium (1929) conduisent inévitablement à de nouvelles sonorités et par conséquent au besoin de nouvelle(s) écriture(s) qui représenteront les nouveaux timbres, les nouvelles techniques de composition et de jeu musical. En plus de chercher à produire une multitude de sons inouïs, au-delà des notes de la gamme occidentale, ces premiers instruments — ainsi que leur descendance (des premiers synthétiseurs analogiques aux boîtes à effets puis aux logiciels et synthétiseurs numériques) — offrent, par leur puissance d’émission et leur technologie, des sons aux nuances d’intensité et de dynamique quasi infinies pouvant atteindre des niveaux de décibels très élevés; niveaux qui sont impossibles à produire par des interprètes se servant d’un instrumentarium classique. Les glissandi très longs et réguliers deviennent simples à obtenir, offrant un continuum de hauteurs, en plus de la gamme discrète qui caractérise beaucoup d’instruments traditionnels occidentaux.

L’enregistrement du son sur un support quant à lui permet de transformer tout type de son en objet musical parfois de la taille d’un échantillon. Les variations de couleurs sonores, les timbres, les textures sont aussi infinis. La réécoute à satiété de tous ces sons fixés, l’écoute au ralenti ou en accéléré permettent à l’oreille d’affiner sa perception et augmentent d’autant l’exigence de précision de la description.

Les premières transcriptions des musiques électroacoustiques n’ont pas répondu à un besoin musical, mais à un besoin juridique.

À l’instar de toutes les musiques, la musique EA relève du caractère éphémère de l’oralité comme du procédural, elle naît dans le temps du jeu; sa qualité dépend de la compétence du compositeur qui la produit. Et comme en plus la musique EA est fixée par enregistrement sur un support, cela réduit fortement le besoin de notation pour la transmission. Elle est en quelque sorte déjà écrite, en tout cas, fixée, mémorisée. On éprouve le besoin de noter éventuellement quelques spécifications techniques — nombre de pistes, distribution spatiale des canaux pour la diffusion, qualité requise des haut-parleurs — pour éclairer l’interprète au moment de la projection du son dans l’espace. Les premières transcriptions des musiques EA n’ont donc pas répondu en premier à un besoin musical, mais à un besoin juridique : déposer les œuvres à la société de gestion des droits d’auteurs (la SACEM en France) qui ne reconnaît les œuvres qu’à travers leur partition. La seconde cause de l’existence des transcriptions étant l’utilité pédagogique indéniable d’un document visuel d’aide à l’écoute ou à l’enseignement. Rien de mieux qu’un dessin pour expliquer les différents types de grincement de porte entendus dans les Variations pour une porte et un soupir (1963) de Pierre Henry, ou un son synthétique créé par un générateur de bruit, ou un traitement informatique du signal sonore numérisé? Quand les plus petits détails et nuances rivalisent d’importance, les compositeurs eux-mêmes n’hésitent pas à inventer des pictogrammes pour faciliter leurs repérages, tant dans le temps de la composition que pour l’élaboration de partitions ou guides d’écoute à des fins pédagogiques et utilitaires pour la diffusion en concert.

En revanche, les musiques mixtes et les musiques électroniques, avec présence d’interprètes jouant en direct sur des dispositifs de génération et transformation du son, requièrent de trouver, plus encore que la musique EA pure, un moyen descriptif efficace, en vue d’une reprise. Souvent, la transmission de l’œuvre se fait à l’aide d’un enregistrement témoin, ou oralement par l’intermédiaire d’un des interprètes ou du compositeur lui-même. Pour préserver la musique EA et les musiques mixtes, les transmettre et les re-produire 3[3. Un livre entier est consacré à ce sujet : Portraits Polychromes, n° 21, Musique et technologie : Préserver — Archiver — Re-produire, Ina, 2013.], plusieurs formes de transcription ont déjà été expérimentées et continuent de l’être. L’objectif de la transcription graphique et de l’écriture dans ce cas, est de mémoriser le jeu musical, et par la suite le divulguer.

Première étape : une notation descriptive et non pas encore prescriptive

Cette première étape, qu’on retrouve dans tout processus de mise au point d’une écriture, n’a qu’une fonction de mémoire, elle tend à conserver l’intégrité du message musical. S’en suit une prolifération de productions plus ou moins explicites quant à la représentation des sons originaux, plus ou moins avancées sur le terrain de l’abstraction.

Bien qu’aujourd’hui on n’en soit plus complètement à ce simple stade, pour la transcription graphique des arts sonores du XXe siècle, on entend encore trop souvent des remarques sur la trop grande subjectivité, voire l’inutilité de leurs transcriptions graphiques. Elles ne seraient que caprices esthétiques et surtout inopératoires pour un interprète, même de bonne volonté.

Souvenons-nous ici que l’écriture classique occidentale de figures de notes sur des portées tracées, puis plus tard imprimées, sur du papier, avec une échelle de temps et de tempo, s’ébauche au VIIIe siècle pour aboutir enfin à une forme quasiment fixe avec l’Ars Nova, au XIVe siècle (avec portée à cinq lignes, clés, figures de notes, symboles de nuances…). Soit plus de cinq cents ans pour élaborer une écriture, l’enseigner et la généraliser.

Nous pourrions nous aussi envisager de prendre 500 ans pour mettre au point une écriture de tous les sons musicaux qui puisse alors être apprise et devenir ainsi possiblement prescriptive, c’est-à-dire être écrite préalablement à toute exécution, avec des symboles connus, permettant une réversibilité avec la construction sonore. L’objectif étant de dépasser le niveau de la première étape descriptive ou mémorielle et atteindre le stade de la création. Rappelons-nous aussi que beaucoup de très grands compositeurs de musique prescriptive ont souvent déclaré écrire à partir de leur écoute : Messiaen inspiré par les chants d’oiseaux, par exemple. Ou bien Stravinsky inspiré par son propre jeu instrumental, qui écrit :

En effet, je compose au piano et je ne m’en plains pas. Bien plus, je pense qu’il est mille fois préférable de composer au contact direct de la matière sonore que de composer en imaginant cette matière. (Stravinsky 1962, 14)

Il y a donc sans cesse superposition des deux démarches : procédurale (à partir de l’écoute et du geste) et prescriptive.

Après avoir adopté des unités de mesure générales (le décibel en 1923, le hertz en 1888, le tempo exprimé en nombre de battements par seconde, le spectrogramme…) — tous intégrés aux appareils contemporains de production de sons — les nouveaux instruments électroniques se sont progressivement standardisés, déjà dans leur connectique 4[4. La norme MIDI a été présentée pour la première fois en 1983.] mais aussi dans leurs formats. Aujourd’hui presque tous les synthétiseurs existent en version virtuelle et les traitements sonores se présentent sous la forme de plugins qu’on intègre dans des séquenceurs. Mais une fois les œuvres composées et jouées, il manque encore souvent des moyens simples de mémoriser et donc reconnaître les effets dynamiques (mouvements spatiaux, évolution des courbes d’intensité dans le temps) et les évolutions timbrales qui ont été utilisés au cours de la fabrication de chacune des voies de mixage. L’analyse du signal et la mise au point de descripteurs audios (de spectres, de pics, de phase) sont apparues à partir des années 2000, et continuent de s’améliorer. En bref, on sait garder un enregistrement global d’une œuvre complexe, mais on a du mal à la re-composer son par son.

Déjà conscient de ce risque, le compositeur Gilles Racot, en 1985, avait noté sur un cahier tous les réglages qu’il avait pratiqués dans le logiciel Syter, ancêtre des GRM Tools 5[5. GRM Tools est un ensemble de logiciels de traitement sonore à l’usage des musiciens, développé au Groupe de Recherches Musicales. La première version date de 1992.], au cours de la composition de sa pièce Anamorphées. Ce fut une sage idée car quelques années plus tard, alors que les plateformes informatiques avaient tellement évolué que l’enregistrement original n’était plus lisible, il avait pu re-composer ses éléments et retrouver les mêmes sons.

Idem pour l’œuvre Saturne (1979) d’Hugues Dufourt qu’une équipe de chercheurs a décidé de remonter 6[6. Dans le cadre du projet français de recherche Gamelan : un environnement pour la Gestion et l’Archivage de la Musique et de l’Audio Numérique. Projet financé par l’Agence Nationale de la Recherche (ANR) en 2010–2012 et coordonné par l’IRCAM, Ina-GRM, UTC et EMI Music France.] en 2009, soit 30 ans après sa création. Cette œuvre pour ensemble électrifié (22 musiciens dont 4 équipés d’instruments électrifiés : Ondes Martenot, orgue, synthé et guitare) a cependant été rejouée à de nombreuses reprises mais modifiée au gré de la disponibilité des instruments électroniques et des contraintes techniques propres à chaque concert. Finalement après un travail de fourmi de la part des chercheurs pour essayer de comprendre les indications manuscrites (parfois erronées) sur la partition des différents interprètes; après une enquête auprès des différents acteurs de l’époque y compris le compositeur, il a fallu se rendre à l’évidence que la pièce re-créée en 2010 n’était pas totalement identique à l’original mais qu’au moins le fait de s’interroger sur sa re-production contribuait à sa sauvegarde (Geslin 2013).

Une recherche d’automatisation de la transcription

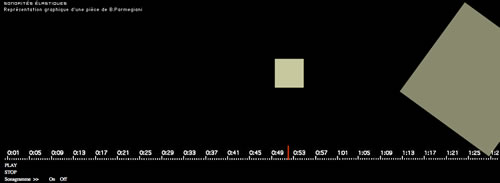

En 2016, le Groupe de Recherches Musicales possède environ 500 partitions ou relevés graphiques sur papier, remontant aux années 1950 pour les premiers relevés de Pierre Schaeffer. À l’observation de ces relevés, on remarque une recherche constante d’automatisation de la transcription avec les outils les plus perfectionnés de chaque époque : des systèmes électromécaniques comme le sonagraphe, dans les années 1950, qui enregistrait le spectre d’un son sur un cylindre (par tronçons de 2,4 secondes), jusqu’à l’informatique à l’aide du premier logiciel Acousmographe en 1995 (outil d’aide à l’analyse de l’écoute et à la transcription) et sa version 3.7.2 en 2013. L’Acousmographe permet d’afficher automatiquement le spectre et la forme d’onde d’une séquence qui peut atteindre une grande durée (jusqu’à trois heures) sur une ligne de temps exprimée en secondes. Aujourd’hui, les représentations des musiques sur support papier qu’on avait connues dans les premiers temps de la musique EA sont supplantées par des transcriptions sur l’écran d’ordinateur, avec apparition des premiers plugins de reconnaissance automatique et coloration de similitudes, entre certains traits musicaux, comme Timbre Scope (2011) de Sébastien Gulluni. 7[7. Timbre scope, développé pour l’analyse des musiques électroacoustiques, permet de réaliser une segmentation automatique. Voir Gulluni 2011.] D’autres logiciels d’aide à l’écoute et à l’analyse du sonore existent, notamment iAnalyse (2007 par Pierre Couprie), inspiré de l’Acousmographe, qui s’est spécialisé sur l’analyse des musiques utilisant les partitions écrites traditionnelles.

Des symboles abstraits et codés qu’il faut apprendre

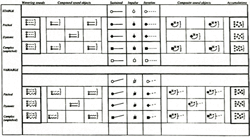

Certains symboles, réunis en bibliothèques, sont déjà allés très loin dans la description morphologique des sons, comme le langage Sonova mis au point par le musicologue norvégien Lasse Thoresen, à partir des années 1970 (Fig. 1). Sa classification de types de sons et d’objet sonores suit les tableaux de description typo-morphologique des sons, établis par Pierre Schaeffer dans son Traité des objets musicaux (Schaeffer 1966, 389–472), et de la spectromorphologie de l’anglais Denis Smalley (1995). Thoresen a attribué un symbole graphique à chaque critère de perception morphologique (masse, dynamique, timbre harmonique, profil mélodique, profil de masse, grain, allure) et chaque type, genre, classe ou espèce (hauteur, intensité, durée). On dispose ainsi de plus de 300 symboles pour représenter les sons, dans un langage qui se veut univoque. 8[8. Cette bibliothèque de symboles est intégrée dans le logiciel d’aide à la transcription graphique du sonore, l’Acousmographe, qui est disponible sur le site du GRM.] Il reste à apprendre tous ces symboles pour les rendre opérationnels, ce qui est le cas de quelques musicologues qui devront à leur tour les enseigner à d’autres musiciens, en attendant des systèmes semi-automatisés d’aide à la reconnaissance.

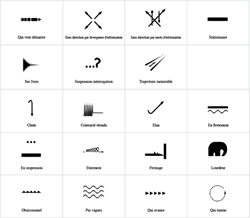

Dans le même ordre d’idée, la description des musiques à partir des Unités Sémiotiques Temporelles (UST) — à la suite également des travaux de Schaeffer, par le Laboratoire Musique et Informatique de Marseille de 1991 à 1996, fondée sur une recherche du sens de la musique au cours de sa réception — a enfin trouvé une série de symboles graphiques applicables à ses 19 figures de style décrivant le comportement dynamique des sons et des musiques (Fig. 2). 9[9. En 2016, ces symboles ont aussi été intégrés dans le logiciel Acousmographe.]

Finalement on a diverses propositions de symboles qui tentent chacune de s’imposer. Mais comme nous le rappelle l’anthropologue Clarisse Herrenschmidt :

Les codes sont des langages techniques, arbitraires, consciemment calculés et écrits par des spécialistes pour le travail des machines dans l’industrie productive, guerrière, financière et sociale. (Herrenschmidt 2010, III)

Comme pour le langage Sonova, la phase suivante de développement pour les représentations d’UST ou d’autres systèmes de notation symbolique pour les pratiques EA va consister à les enseigner au plus grand nombre possible de futurs utilisateurs dans un projet idéal de généralisation de la description morphologique du sonore et du musical.

La constitution d’une nouvelle écriture musicale

Des excursions dans l’histoire générale de l’écriture peuvent nous éclairer sur les raisons de la difficile harmonisation des transcriptions graphiques actuelles en musique. Des pictogrammes et idéogrammes (comme dans les écritures chinoise ou égyptienne) qui sont composés d’un assemblage de traits et de figures simples, parfois allégoriques, jusqu’aux dessins les plus extravagants, on trouve aujourd’hui dans les transcriptions de musiques toute une palette de symboles, de signes, de codes qui ne peuvent être compris que des seuls initiés. On ne peut pas encore parler d’une écriture codifiée transmise à grande échelle : au sens moderne de la relation entre graphie et prononciation.

Wang Xizhi (330–361), l’un des maîtres chinois les plus vénérés en calligraphie disait :

L’écriture a besoin de sens, tandis que la calligraphie s’exprime surtout à travers la forme et le geste; elle élève l’âme et illumine les sentiments. (Cité dans Mediavilla 2013, 7)

Ainsi nos symboles comme Sonova ou UST de même que les formes et les dessins colorés que les musicologues d’aujourd’hui inventent pour les besoins de la représentation dans les transcriptions graphiques répondent-ils à la définition de la calligraphie. L’idéogramme de la calligraphie est une figure qui n’est pas liée à un son, il relève de l’écrit pur; il ne peut pas se dire hors contexte, mais se lire. C’est un signe mouvant dont la valeur change en fonction du contexte.

De même, les valeurs variables que nous attribuons à chaque représentation graphique de musiques seraient le signe que nous n’en sommes encore qu’à un stade précédent l’écriture : aucun son précis n’est associé à un graphisme précis empêchant toute réversibilité image et son. Tout au plus, serions-nous déjà dans un début de métissage des modes de représentation : la chercheuse Véronique Alexandre Journeau montre comment les partitions graphiques des musiques chinoises anciennes, en tablatures, décrivent les nuances sous la forme d’idéogrammes assortis de dessins et textes poétiques (Alexandre Journeau 2015). N’oublions pas non plus que la musique ne cherche pas en premier lieu à véhiculer un sens — comme le langage — mais à toucher l’auditeur au plus près de sa sensorialité et de ses émotions.

Alors que la calligraphie est intrinsèquement liée au support papier, aujourd’hui notre support est un écran d’ordinateur où l’on peut corréler les gestes, les sons et les images parfois en temps réel.

Notons aussi qu’il n’est pas étonnant qu’à la suite des travaux de Schaeffer sur la morphologie des sons, les premières représentations de la musique électroacoustique relèvent plutôt du domaine des morphèmes et non des phonèmes. 10[10. Le phonème est le plus petit segment des écritures reposant sur la phonétique, comme l’écriture linéaire syllabique de la tradition grecque, avec son alphabet complet achevé en 750 av. J.-C.] L’objectif étant de représenter des objets sonores complexes.

Sachant qu’historiquement, l’idéogramme s’est muté en phonogramme très tôt (Christin 2009), nous pouvons espérer que pour nos représentations, nous pourrons aussi rétablir ces liens. Jean-François Champollion, l’égyptologue originel, lui-même fut très surpris de découvrir que les hiéroglyphes renvoyaient aussi à un système phonétique.

Des solutions pourraient émerger de l’usage de nouvelles techniques comme le machine learning, voire le deep learning, mais avons-nous aujourd’hui un corpus suffisant de transcriptions graphiques déjà réalisées et réunies dans une base de données pour obtenir des résultats fiables? Ceci pourrait être un bel enjeu de collaboration entre chercheurs.

Deuxième étape : une écriture prescriptive totalement aboutie (dans quelques siècles?)

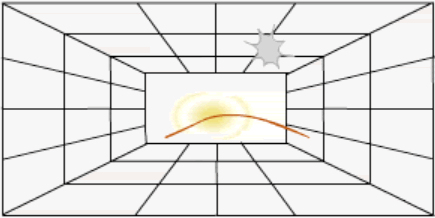

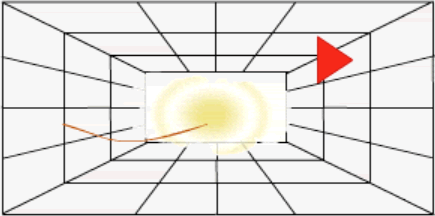

Pour nous, aujourd’hui, la tâche reste complexe car l’instrumentarium et les sons sont sans limites et non encore fixés. La standardisation de l’écriture ne pourra venir qu’avec la standardisation des instruments, mais pour l’instant, leur multiplication ne fait qu’empirer le problème. En attendant, il nous faut continuer de décrire les sons, tous les sons, puis leurs agrégats (objets sonores, samples) et leur évolution dans le temps et l’espace avec le plus de précision possible. La décomposition du signal en données numériques devrait pouvoir le permettre. Alors à l’aide des machines nous pourrons re-composer la musique. En fait, on assiste à un renversement : la partition prescriptive est en train d’être remplacer par des partitions descriptives. Certains chercheurs parlent déjà de « partitions-instruments » (Zénouda 2015, 252) où l’interface homme-machine et la représentation graphique seraient confondues, comme dans certains jeux vidéos-sonores, dont Lemur (Fig. 3) et synthPond (Fig. 4), entre autres. 11[11. Lemur est un contrôleur en forme d’appareil et à écran multi-tactile sur lequel l’utilisateur peut créer sa propre interface de contrôle. Séquenceur et jeu développé par Zach Gage, synthPond permet à l’utilisateur de placer et bouger des « nœuds » dans un champ et de laisser sonner sa « partition » dans un espace 3D. Voir, par exemple la vidéo « synthpond » (3:23), postée sur YouTube par « wiretotheear » le 21 janvier 2009.] Dans ce cas, l’écran remplace la feuille de papier. La rupture technologique consiste à substituer l’informatique à l’imprimerie, et remplacer le livre de théorie musicale par un tutoriel.

L’anthropologue Clarisse Herrenschmidt, spécialiste de l’histoire de l’écriture, précise la fonction de l’écriture :

Écrire, c’est transférer, faire passer la parole orale ou intérieure, la langue en sa forme intériorisée et sans énoncé, la pensée floue ou des bagages mémoriels, à la fixité des signes graphiques. (Herrenschmidt 2010, 10)

Ainsi la figuration d’un acte de parole conduit-elle à l’écriture. Et si la parole n’est pas un code, la langue en est déjà un. D’où une extrapolation facile avec le son et la musique où l’on peut considérer les figurations diverses du son dans les transcriptions graphiques de nos musiques non écrites occidentales, depuis le milieu du XXe siècle, comme un premier pas vers une écriture. Mais pour s’appeler écriture, ces nouveaux signes doivent pouvoir être déchiffrés hors de leur contexte de production.

Vers un nouveau champ esthétique : le multimédia

Ce faisant, toutes ces transcriptions graphiques du son et de la musique nous éloignent du champ auditif pour rejoindre le champ visuel. Les supports de mémoire — majoritairement le papier, mais antérieurement les parchemins, les tablettes d’argiles, jusqu’aux murs des grottes du paléolithique — servent de réceptacle aux gestes producteurs de symboles représentant les nombres, les idées, les sons. Ainsi, la représentation graphique des musiques ne s’adresse pas en premier lieu à un auditeur mais à un lecteur qui, si, et seulement s’il est éduqué à la musique peut envisager une réversibilité entre audition et lecture, sans quoi un même graphisme peut conduire à différentes interprétations sonores. Toute une dialectique entre mémoire auditive et mémoire visuelle entre alors en jeu.

Nos transcriptions récentes de musiques plus proches des idéogrammes que des phonogrammes répondent donc principalement aux lois du graphisme, et secondairement de la musique. D’où leur proximité avec les arts graphiques et le multimédia. Ce nouveau champ d’exploration artistique des ambivalences entre son et image risque fort de se développer encore et encore.

À l’opposé de la tendance à élaborer des bibliothèques de symboles abstraits comme Sonova, les représentations graphiques « libres » (majoritaires en nombre) jouent sur le parallèle entre les médias sonores et visuels à la racine d’un art intermédia. On remarquera qu’elles se placent à une échelle de perception plus grande que les représentations codées avec Sonova ou UST qui fonctionnent mieux sur des échantillons sonores d’une durée moyenne de quelques secondes alors que d’autres types de représentations (animées notamment) sont plus adaptés à des sections plus longues allant jusqu’à quelques minutes.

Dans les exemples de recherche sur la représentation de séquences longues, l’Acousmographe n’est pas utilisé dans tous les cas. Les outils déterminent le style de représentation : Flash et QuickTime permettent par exemple de visualiser le curseur sur la ligne de temps.

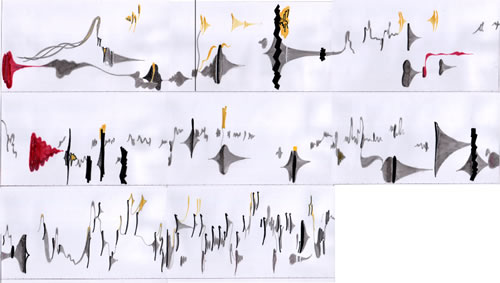

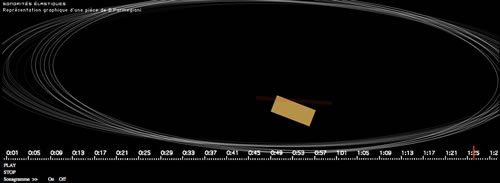

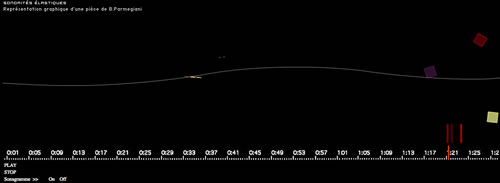

Encore un travail de titan pour une synchronisation des éléments visuels point par point dans Flash pour ces trois extraits (Figs. 6–8) de la transcription de l’Étude élastique de Parmigiani (Vidéo 2).

La notation et la performance peuvent être subjectives et on remarque aussi qu’il n’y a pas de norme dans la notation des éléments graphiques. Ainsi, l’œuvre de Parmegiani pourrait aussi bien être représentée sous une autre forme que celle proposée par Samuel Rousselier. En opposition à l’approche linéaire choisie par Rousselier — une ligne de temps rappelant le principe de lecture de gauche à droite — David Boisbourdin a choisi de développer une notation de l’espace (Figs. 9–10).

Cependant, plus on s’éloigne de la représentation graphique et qu’on se rapproche de l’analyse on reconnait quelques grands axes :

- le repérage général de la grande forme de l’œuvre (divisée en parties);

- le repérage détaillé des éléments sonores remarquables (objets sonores);

- voire l’analyse / représentation à partir des UST (unités sémiotiques temporelles) développées par le MIM (Musique Informatique Marseille);

- ou encore l’analyse / représentation suivant les critères de la spectromorphologie de Denis Smalley…

Conclusion

La recherche d’une notation en musique EA, fruit d’une simple demande juridique et pédagogique au départ, a rapidement débouché sur la production d’une multitude de représentations très variées esthétiquement et sans cohérence apparente. Les analyses de ces transcriptions nous conduisent à remonter vers la source de la rupture technologique qui les a déclenchées — l’électrification des instruments producteurs de son, l’enregistrement, l’informatique — pour établir leurs liens avec le nouvel instrumentarium électrifié (pléthorique) apparu dès la fin du XIXe siècle. Aujourd’hui, plus de cinquante ans après les premiers essais de transcriptions graphiques des musiques EA, à l’instar de la standardisation des appareils producteurs de sons, on se préoccupe de standardiser les transcriptions qui permettront peut-être de re-produire, voire de créer ex nihilo des musiques à interpréter. Mais avant d’avoir une fonction créative, la notation a d’abord une fonction de mémoire. Le fait de replacer l’histoire de la recherche sur la notation EA dans le contexte général de l’invention des écritures permet, de mieux apprécier la cohérence globale de son évolution : nous n’en sommes qu’aux premiers balbutiements d’une nouvelle notation de la musique. Cette confrontation nous permet aussi de vérifier que nos représentations graphiques ne s’adressent pas en premier lieu à un auditeur mais à un lecteur, d’où l’ouverture vers le monde de la création visuelle et multimédia.

Bibliography

Alexandre Journeau, Véronique. « Une notation musicale des images insufflant l’intuition du geste » In Son — Image — Geste, une interaction illusoire? Sous la direction de Lenka Stranska et Hérvé Zénouda. Collection Ouverture philosophique. Paris : L’Harmattan, 2015, p. 201–226.

Christin, Anne-Marie. L’image écrite ou la déraison graphique. Paris : Flammarion, 1995, -2009.

Gayou, Evelyne (dir.). Portraits Polychromes, n° 21, Musique et technologie : Préserver — Archiver — Re-produire. Ina, 2013.

Gayou, Evelyne. GRM — Le Groupe de Recherches Musicales : Cinquante ans d’histoire. Paris : Fayard, 2007.

Geslin, Yann. « Saturne d’Hugues Dufourt, ou la préservation d’une œuvre avec électronique ». In Portraits Polychromes, n° 21, Musique et technologie : Préserver — Archiver — Re-produire. Sous la direction d’Evelyne Gayou. Paris : Ina, 2013, p. 127–144.

Gulluni, Sébastien. « Un système interactif pour l’analyse des musiques électroacoustiques ». Thèse de doctorat sous la direction de Gaël Richard, Télécom ParisTech, 2011. http://tel.archives-ouvertes.fr/pastel-00676691/document [consulté le 25 février 2017]

Herrenschmidt, Clarisse. Les trois écritures. Langue, nombre, code. Paris : Gallimard NRF, 2010.

Mediavilla, Claude. L’Abcdaire de la calligraphie. Flammarion scriptorial, 2013.

Schaeffer, Pierre. Traité des objets musicaux. Paris : Le Seuil, 1966.

Smalley, Denis. « La spectromorphologie, une explication de la forme des sons ». In Louise Poissant, Esthétique des arts médiatiques, Tome 2. Montréal : Presses de l’Université du Québec, 1995, p. 125–164.

Stranska, Lenka et Hérvé Zénouda (dirs.). Son — Image — Geste, une interaction illusoire? Collection Ouverture philosophique. Paris : L’Harmattan, 2015, p. 201–226.

Stravinsky, Igor. Chroniques de ma vie. Paris : Denoël, 1962, -2000.

Zénouda, Hervé. « Apport des SIC et des NTIC à l’analyse du “fait musical” contemporain ». In Son — Image — Geste, une interaction illusoire? Sous la direction de Lenka Stranska et Hérvé Zénouda. Collection Ouverture philosophique. Paris : L’Harmattan, 2015, p. 247–254.

Social top