Les quatre niveaux de réception d’une œuvre électroacoustique

Introduction

Depuis les expérimentations et les premières œuvres fixées sur bande des grands inventeurs de la musique électroacoustique, les évolutions technologiques ont accompagné les évolutions de style en fournissant de plus en plus de facilité à créer des sons nouveaux, à complexifier leurs arrangements et à sophistiquer leur diffusion. Aujourd’hui le numérique permet une virtualisation complète des outils de composition, suggérant l’idée d’une libération définitive de toute contingence externe. Il y a les musiciens raisonnables, qui flairent là un mythe, car l’art aura toujours besoin de contraintes et d’écoles. D’autres, plus téméraires, plongent dans l’ivresse d’un océan sans bornes, mais s’étonnent du peu d’adhésion des auditeurs, qu’ils tiennent parfois pour idiots ou bornés. Naturellement, un projet musical dédaignant toute contrainte n’est pas viable, en premier lieu parce que le processus de création musicale est tributaire du processus de l’écoute humaine, ô combien l’objet de perturbations, limitations et subjectivités.

Le processus d’écoute

Ecoute et audition

Pour l’homme ou l’animal, l’audition est la faculté de percevoir des sons. Une ouïe fine est souvent plus indispensable à sa sécurité qu’une vue perçante. Le fait d’entendre ou de ne pas entendre n’a pas de caractère intentionnel, sauf pour atténuer la perception en se bouchant les oreilles ou en s’éloignant de la source sonore, ou pour intensifier la perception via un stéthoscope ou un microphone. Comme les autres sens, l’audition fonctionne aussi pendant le sommeil, et permet un réflexe de réveil en cas d’alerte ou quand ce satané réveil-matin retentit.

Par contre, le fait d’écouter nécessite une attitude de veille, qui consiste à prêter intérêt à ce qui est entendu. Il demande un effort d’attention pour analyser les sons, en les discriminant selon l’intérêt que chacun peut susciter. L’écoute permet au sujet de se représenter l’environnement sonore, de communiquer verbalement avec ses semblables, ou de communiquer non verbalement par la musique.

Qu’il concerne la représentation de l’environnement sonore ou la communication avec autrui, le processus d’écoute repose totalement sur le processus d’audition, c’est à dire que l’écoute ne peut s’appliquer quhisoire’aux résultats de l’audition. A noter que le silence n’arrête ni l’audition ni l’écoute, qui seraient comme en panne de carburant : au contraire, sa rareté ne fait que les stimuler.

Nous venons d’utiliser le terme de « processus ». Un processus est un ensemble d’activités transformant des éléments en entrée en éléments en sortie, dont le résultat attendu est un produit. 1[1. Cette définition rigoureuse et complète provient de la norme ISO 9000:2005 : Systèmes de management de la qualité — Principes essentiels et vocabulaire. Les éléments en sortie incluent aussi des déchets, qui ne font pas partie du produit final.] Selon le domaine d’application, le terme d’élément sera remplacé par matériau, donnée, objet, pièce, information, résultat. Une approche superficielle s’intéressera seulement aux produits d’un processus, mais une analyse globale implique de s’intéresser tout autant aux éléments en entrée, qui sont eux-même les produits d’autres processus en amont.

Ainsi, s’intéresser globalement au processus d’écoute de la musique électroacoustique amène à s’intéresser de près aux processus sous-jacents, le point de départ étant la mise en œuvre du support enregistré afin d’activer les haut-parleurs. Les processus encore plus amont aboutissant à faire exister ce support enregistré concerneront la création et l’écriture de la musique, qui seront abordés en seconde moitié de cet article.

L’audition, les vibrations et l’acoustique

Qu’on appelle cela du bruit, du son, de la musique ou du vent, le phénomène de base est mécanique : des molécules d’air en mouvement font vibrer les tympans de l’auditeur. Ce mouvement est provoqué à distance par les membranes des différents haut-parleurs, par des instruments de musique et des voix, ou à proximité grâce à des écouteurs. Il s’y ajoute un bruit de fond d’ambiance jamais nul et les bruits internes corporels de l’auditeur.

Une source sonore, telle qu’un haut-parleur, ne propulse pas les molécules d’air vers les auditeurs à la manière d’un ventilateur. Les mouvements moléculaires sont des vibrations locales qui se propagent en ondes élastiques à une vitesse de 345 m/s autour de la source. Sur le trajet se trouvent différents vecteurs ou obstacles réfractants, réfléchissants et absorbants : le sol, les murs et plafonds et des objets, à l’intérieur desquels les ondes élastiques se propagent à plus grande vitesse que dans l’air, modifiant ainsi la forme des vibrations.

La fonction de l’oreille n’est pas d’utiliser la membrane du tympan pour capter la pression ou la vélocité de l’air, comme le fait un microphone. En effet les organes de l’oreille interne ont la faculté de mesurer directement l’intensité et le spectre fréquentiel des vibrations reçues, et de transmettre ces informations d’ordre acoustique vers l’hémisphère cervical concerné, via les signaux électrochimiques du nerf auditif. 2[2. Naturellement, cette conversion du domaine temps vers le domaine fréquences n’a pas la rigueur déterministe et linéaire d’une fonction FFT (Fast Fourier Transform) exécutée par un processeur numérique! En effet le nerf auditif comprend des milliers de canaux de collecte du flux d’information, qui se présente alors de manière chaotique, mais néanmoins partiellement intelligible par les processus en aval (Vergnon 2008, 64–91).]

A l’intérieur du cerveau, ces informations sont étalées chronologiquement dans des mémoires temporaires de quelques secondes, qu’on appelle trivialement « mémoire phosphorescente », ou « empan de mémoire temporaire ». Les circuits neuronaux y accomplissent une analyse morphologique qui identifie des signes potentiellement signifiants. Dans un langage classique, pour les distinguer des « bruits » qui ne seraient pas potentiellement signifiants, ces signes sont appelés « sons », caractérisés par la hauteur et le timbre. Nous préférerons le concept Schaefferien d’« objet sonore » (Schaeffer 1966, 268) 3[3. Ce concept d’objet sonore signifie le sonore en tant qu’objet élémentaire d’écoute acousmatique, et non l’objet physique émettant le son. Il peut y avoir confusion pour la musique écrite, où les différents timbres à faire entendre sont restreints à ceux des instruments standards de l’orchestre.], plus adapté à une conception élargie de la musique. Ainsi, en continu, le processus d’audition met à disposition du processus d’écoute des objets sonores, caractérisés par leur morphologie en termes de « formants ». 4[4. Le mot « formant » vient de la phonétique, et s’applique aux constituants du timbre des phonèmes. Nous étendons sa définition pour l’appliquer aux objets sonores : on appellera « formant d’un objet sonore » toute forme élémentaire identifiable qui organise de manière reconnaissable la matière sonore, aussi bien suivant son timbre (ou sa couleur) instantané que la dynamique de celui-ci dans le temps et en intensité (Platel 2007, 91). Le mot « formant » était aussi utilisé pour un signal d’enveloppe de synthétiseur analogique.]

Ce rapide et simpliste aperçu du processus d’audition indique qu’il repose sur un processus intermédiaire d’analyse acoustique. La figure 2, dont le tableau peut être parcouru aussi de bas en haut, résume ce schéma, avec, entre parenthèses, les caractéristiques de chaque élément en entrée/sortie.

Ces processus ne sont pas enchaînés successivement, ils fonctionnent simultanément. A ce point de notre observation, un même phénomène, la musique en train d’être écoutée, est décrit simultanément par trois espaces représentatifs :

- l’espace des ondes de vibration, qui est l’« espace physique » trivial à trois dimensions,

- l’espace des signaux acoustiques représentés par leurs spectres fréquentiels, soit l’« espace acoustique »,

- l’espace des objets sonores, que nous appelerons « espace sonore ».

Les quatre niveaux d’espace

L’espace musical des êtres sonores

Le processus d’écoute vise en premier lieu à trouver un sens aux objets sonores portés à connaissance de l’auditeur via le processus d’audition. Dans l’activité neuronale concernée, il s’établit des relations avec des objets déjà mémorisés précédemment : depuis la naissance de l’auditeur jusqu’aux précédentes secondes, ainsi que les archétypes transmis de génération en génération. 5[5. R. Murray Schafer a catalogué le patrimoine des archétypes sonores transmis de génération en génération au cours de l’histoire humaine ancienne et moderne (Schafer — traduction française 1979, 197–200).] Bien que semblable pour tous, ce processus produit un résultat subjectif, inhérent à l’histoire de chaque personnalité, alors que le processus d’audition produit un résultat qu’on peut qualifier d’objectif pour des individus dans les mêmes conditions physiques et acoustiques.

Comment définir les produits en sortie du processus d’écoute?

J’ai été tenté d’utiliser aussi le terme Schaefferien d’« objets musicaux », qui distingue les objets sonores pour lesquels l’auditeur manifestera un intérêt intentionnel dans le cadre d’une œuvre musicale. 6[6. Voir Pierre Schaeffer, Traité des objets musicaux (Paris: Seuil, 1966), p. 480.] Cependant pour Schaeffer, s’appuyant sur l’expérimentation, cet intérêt est objectif, selon la position de l’objet musical dans la structure musicale, et indépendant du sujet écoutant. La notion d’« unité sémiotique temporelle » (UST) 7[7. Les Unités Sémiotiques Temporelles (UST) sont un outil d’analyse musicale élaboré par les musiciens-chercheurs du MIM. Développées à l’origine pour les musiques électroacoustiques, elles peuvent aussi s’appliquer d’autres formes artistiques : danse, arts plastique (MIM. 2004).] serait également candidate, car elle exprime le résultat réutilisable de l’abstraction de formants d’objets sonores. De même que le précurseur « catalogue des sons numériques » de Jean-Claude Risset 8[8. Ce catalogue s’appuyait sur les possibilités du logiciel Music V (Risset 1969).], la liste des 19 UST constitue une collection d’invariants objectifs, dans la ligne de la vocation universaliste et unificatrice de l’approche scientfique.

Pour traduire le résultat subjectif du processus d’écoute, j’ai préféré un nouveau terme, celui d’« être sonore », qui serait l’abstraction de l’objet sonore telle que mémorisée en temps réel par le sujet écoutant, et susceptible d’être ultérieurement remise en relation en temps réel. L’être sonore pourrait être vu comme une aggrégation personnalisée d’UST. Par souci de cohérence avec mon ouvrage Musique Imaginaire de 2007, je continuerai à utiliser le terme d’être sonore dans la suite de cet article, tout en étant ouvert à une terminologie consensuelle si cela est possible. 9[9. Par exemple, en analyse informatique par objets, l’être sonore serait une « classe » dont l’objet sonore serait une « instanciation », et dont les formants seraient les « caractéristiques ». Le mécanisme d’« abstraction » serait mis en œuvre par l’écoute (y compris en vue d’analyse musicale), et celui d’« héritage » par la création.]

L’ensemble des être sonores, enfouis en mémoire permanente et susceptibles d’être réveillés par des objets sonores lors de l’écoute musicale, sera notre « espace musical », propre à chaque sujet écoutant. Au delà des périodes d’écoute, ces être sonores peuvent être sollicités par l’imaginaire du sujet, pendant les rêves et lors des activités créatives. Enfin, le cerveau étant capable d’établir des liaisons rapides longue distance entre espaces dédiés aux différentes activités, les expériences visuelles pourront interférer avec l’espace musical pour y susciter de nouveaux être sonores en dehors de l’expérience auditive. Par exemple les arts plastiques peuvent évoquer de la musique, et réciproquement. 10[10. « Le cerveau de l’artiste crée au hasard des formes, des couleurs, des mouvements…, et seules subsistent les formes… qui peuvent rentrer dans la mémoire à long terme de l’artiste » (Changeux 1994).]

La figure 3 présente l’architecture du modèle : les niveaux d’espace, les processus en interface, les élément en entrée/sortie avec, entre parenthèses, les caractéristiques de chacun.

Analogie avec le modèle OSI de communication entre systèmes d’information

Depuis 1985 la plupart des fournisseurs informatiques reconnaissent la norme ISO 7498 Open System Interconnection (OSI) pour faire communiquer des systèmes informatiques hétérogènes. Cela signifie qu’ils sont parvenus à un langage commun, même si des dialectes subsistent. Ce modèle propose un découpage en couches pour structurer les échanges entre systèmes, un système pouvant être par exemple aussi bien le système d’information d’une grande entreprise, l’ordinateur personnel d’un particulier, un téléphone, que l’automate de pilotage d’une machine-outil. Le modèle OSI comprends sept couches : physique, liaison de données, réseau, transport, session, présentation, application. Même si les échanges, comme via Internet, ne respectent pas strictement la norme, ils ont néanmoins le mérite d’être décrits vis-à-vis de celle-ci.

La notion de couche de communication avait été mise en œuvre bien antérieurement pour les réseaux telex et téléphonie. Son principe est que la signification est encapsulée dans des protocoles emboités en « poupées russes », de telle sorte que le signifié d’un niveau est lui-même le signifiant du niveau supérieur. Ceci présente un double intérêt :

- la séparation des couches permet l’interopérabilité : par exemple, une conversation téléphonique sera gérée au niveau de l’usager exactement de la même façon (appel, tonalité, numérotation, sonnerie, etc.) via un réseau filaire analogique, un réseau optique numérique ou un réseau radio mobile, la communication pouvant même être acheminée en empruntant ces trois types de couche physique;

- les communications étant naturellement et à tout moment menacées ou dégradées par du bruit ou des incidents de fonctionnement, le modèle impose de résoudre les problèmes au niveau où ils peuvent survenir plutôt que par les niveaux supérieurs, voire par l’usager final.

C’est surtout ce second point qui nous intéressera pour les processus de la musique : chaque couche, physique, acoustique, sonore et musicale, possède ses propres problèmes et contraintes incontournables pour l’auditeur et, par conséquent, pour les musiciens.

Problèmes, contraintes et bonnes pratiques pour améliorer l’écoute

Dans l’espace physique : l’art du compromis

Dans l’espace physique, les conditions doivent être réunies pour que les ondes émises par les différentes sources sonores parviennent fidèlement aux deux tympans de chaque auditeur. Il s’agit souvent de problèmes d’acoustique des salles grandes ou petites, du plein air ou des installations sonores autour desquelles l’auditeur peut circuler :

- qualité intrinsèque des projecteurs sonores, adéquation aux dimensions spatiales;

- respect de la physiologie de l’audition humaine concernant les pressions admissibles, le seuil de sensibilité, la gestion de la fatigue auditive;

- réduction des bruits non désirés ou, au contraire, participation des bruits ambiants à la performance, coexistence des installations sonores dans une exposition;

- contrôle des réflexions, des diffractions et différentes causes de déformation de l’onde dues à la géométrie de l’espace où elle se propage, de la nature des matériaux qu’elle traverse ou sur lesquels elle se réfléchit, y compris les auditeurs eux-mêmes;

- optimisation de la réception stéréo ou multiphonique : gestion de la distance et de la phase des hauts parleurs, acousmonium, home-cinéma;

- recherche d’une audition acceptable et confortable pour toutes les places d’auditeurs.

Il sera impossible de réunir des conditions de fidélité parfaite : les essais vérifieront que les défauts inévitables ne détériorent pas l’intelligibilité de la musique. Réciproquement, le compositeur pourra doser la complexité musicale en fonction des lieux de diffusion où il escompte que son œuvre sera écoutée (depuis l’autoradio ou le téléphone portable jusqu’aux acousmoniums de concert).

Dans l’espace acoustique : l’art de la mise en scène

Bien sûr il n’est pas question d’intervenir matériellement sur le processus de l’oreille interne comme pour la gestion de l’espace physique, mais de prendre en compte au minimum les contraintes découlant de la théorie du signal 11[11. Nous parlons ici de la théorie du signal qui s’appuie sur la transformée de Fourier et sa transformée inverse, à la base des outils courants à notre disposition pour l’analyse et la synthèse, en analogique ou numérique : analyseurs de spectre, filtres et égaliseurs, etc. Il existe d’autres théories exploitées en synthèse sonore, par exemple la transformée en ondelettes ou la transformée en grains (Gabor), mais leurs outils ne sont pas autant accessibles.] : passer outre peut entraîner une cacophonie dépassant les capacités humaines d’analyse acoustique. Cette théorie du signal est, en principe, bien maîtrisée par les électroniciens, ainsi que les professionnels du mixage et du mastering.

L’espace acoustique du processus d’audition est limité par la fenêtre [intensité x fréquence] spécifique à l’audiogramme humain moyen. D’un point de vue systèmique se présentent alors deux types de considérations : les contraintes de coexistence des objets sonore à l’intérieur des frontières et les problèmes aux frontières.

Les contraintes de coexistence ressemblent à ceux de l’organisation d’une chorégraphie pour de nombreux artistes sur une surface scénique réduite. Voici quelques exemples :

- dans la dimension intensité, les sons forts couvrent les faibles;

- dans la dimension fréquence, les sons bruités occupent une large étendue spectrale contigüe, et donc se marchent souvent sur les pieds; or tous les sons musicaux contiennent une part significative de bruit, en particulier lors de l’attaque;

- lorsque des sons utilisent des fréquences voisines, il se produit des battements d’intensité.

L’enregistrement et la diffusion spatialisée multicanal, stéréo ou multiphonique, peut aider à résoudre ces difficultés d’occupation de l’espace, en ajoutant un degré de liberté discernable.

Les problèmes aux frontières sont d’une part assez triviaux : seuils de sensibilité, seuil de douleur, fréquences en deçà ou au delà de la fourchette 20 Hz – 20 kHz. Il y a des effets moins triviaux lorsque des combinaisons de sons génèrent des composantes inférieures à 20 Hz, en principe inaudibles, mais pouvant néanmoins être interprétées par le processus d’analyse acoustique de l’oreille comme des modulations d’intensité ou des grains sonores. 12[12. Voir Platel, Musique imaginaire (Paris: Imagimuse, 2007). Les chapitres 3 et 4 détaillent ces contraintes en regard des courbes isophoniques de Fletcher. A noter aussi que la synthèse granulaire exploite précisément les effets psychoacoustiques des grains de période 10ms–50ms, c’est à dire dans la zone où l’oreille ne sait plus si elle doit interpréter une vibration en tant que son, modulation d’un son, ou des quanta de son. Cette zone d’incertitude peut alors générer des effets inattendus pas toujours heureux (saturations, brouillages, « soupe de graves ») dans certains cas d’intéraction entre objets sonores.]

Les bonnes pratiques consistent à régler harmonieusement les positions et trajectoires des signaux dans un espace acoustique limité, et, peut être, à exploiter dramatiquement les conflits.

Dans l’espace sonore : répétition et nouveauté

Au niveau des objets sonores, le principal problème est l’intelligibilité : faire en sorte que l’auditeur ne soit pas mis en échec dans son processus d’identification d’objets cohérents et dignes d’intérêt. Exprimé autrement, l’objet sonore doit présenter certaines qualités pour être éligible par le processus d’écoute au statut d’être sonore mémorisé de manière permanente.

Le déclic, c’est que l’auditeur détecte une originalité qui focalise son intérêt. Le revers serait que l’objet soit trop original et déconcertant, et donc ignoré ou rejeté. La contraintes s’apparente donc à un passage étroit entre l’écueil de la banalité et celui de l’excès d’originalité.

La théorie de l’information, qui nous vient également du monde des télécoms, peut nous aider (Moles 1972, 93). 13[13. Présenté par l’auteur dans son ouvrage Musique imaginaire (Platel 2007, 61).] En particulier elle a mathématisé comment optimiser le contenu d’un message en fonction de la difficulté pour le transmettre dans un milieu perturbé (ce qui est, en général, le cas). Pour faciliter son identification, il est nécessaire que l’information contenue soit répétée : on instille donc de la redondance dans le message. Mais plus la redondance est élevée, moins on peut alors transmettre une information variée, et la conversation s’éternise. Transposé pour la musique, cet équilibre entre la redondance et la variation incite :

- à ce qu’une certaine répétitivité soit inhérente au message musical, afin de repérer qu’il s’agit bien de musique organisée, et non d’un environnement chaotique;

- à ce que la variabilité soit dosée en fonction de la capacité présumée de l’auditoire à absorber la nouveauté ou la surprise par rapport à l’attente résultant de la redondance.

Dans l’espace musical : du compositeur à l’auditeur, et réciproquement

Jusqu’au niveau de l’espace sonore, les processus sont grosso-modo objectifs, et les problèmes et contraintes relativement similaires pour tous auditoires en conditions similaires.

En revanche, le processus d’écoute est subjectif : chaque individu a son propre espace musical, peuplé des être sonores qu’il a mémorisé sa vie durant. Bien sûr, les bénéficiaires d’une culture commune partageront de nombreux être sonores communs, mais fondamentalement chaque humain est différent.

Dans ce processus, le résultat produit est une réponse émotionnelle à l’information portée par les formants. La manière dont cette information est signifiante dépend des connotations qui s’établissent ou non avec la personnalité qui reçoit la musique.

La théorie de l’information peut encore nous aider pour comprendre ce qui se passe en termes d’efficience de la communication. Pour qu’une information soit compréhensible par un récepteur, il faut :

- soit qu’elle présente explicitement ses propres clés de codage, comme dans le conte musical pour enfants Pierre et le Loup de Sergueï Prokofiev;

- soit que le récepteur partage les clés de codage avec l’émetteur, c’est-à-dire que l’émetteur et le récepteur possèdent préalablement un langage commun.

Concrétement, l’efficience implique un protocole entre les deux parties concernant le niveau de langage commun sur lequel investir : plus ce niveau est élevé (et donc coûteux à acquérir), moins l’information a besoin d’être volumineuse pour transmettre la même signification, et surtout, plus la signification peut être riche à volume d’information égal.

Sur le plan musical : la communication entre musicien et auditeur est d’autant plus riche que les deux se sentent proches culturellement et émotionnellement. Symétriquement, la musique peut être d’autant plus épurée et elliptique, car comprise par ceux qui ont appris le même langage musical.

Peut-on généraliser de bonnes pratiques à ce niveaux? Pour les compositeurs, il s’agira de stratégie réaliste :

- garder patience : ne pas s’étonner ou se décourager si leur auditoire est restreint à une fraction de population culturellement proche, en attendant une éventuelle reconnaissance posthume;

- ou convaincrer l’auditoire de son génie par un marketing assidu;

- sinon s’appuyer sur les styles déjà reconnus du public, en proposant à celui-ci des nouveautés à dose homéopathique.

Les bonnes pratiques vont plutôt en direction des auditeurs, pour les inciter à multiplier leurs écoutes d’œuvres non familières de diverses cultures, se laisser apprivoiser et ainsi élargir les opportunités du frémissement de profonde compréhension.

Intérêt du modèle pour créer et composer

Gérer les pratiques créatives

Pour agir sur la musique, on peut intervenir à chacun des niveaux d’espace : physique, acoustique, sonore, musical que nous avons identifiés. Cela consiste à travailler les éléments propres à ces espaces, ou sur les « media » (supports d’information descriptive) correspondants.

Les pratiques créatives peuvent être spécialisées, référant à un ou plusieurs niveaux d’intervention spécifiques d’un métier donné : ingénieur du son, instrumentiste, chef d’orchestre, compositeur, disc-jockey, etc., dans un esprit bien taylorien de division du travail.

Elles peuvent aussi être intégrées verticalement : c’est le cas de la musique improvisée et de la musique populaire, c’est aussi le cas des compositeurs qui veulent prendre en charge toute la chaîne jusqu’à la performance devant les auditeurs.

L’interprétation a une position spéciale : elle vise la fidélité la plus exigeante aux intentions définies au niveau supérieur. Ainsi le chef d’orchestre interprète le compositeur, l’instrumentiste s’applique à respecter le chef, l’ingénieur du son recherche la « hi-fi »…

La créativité suppose possibilité de choix, et donc d’erreur. L’interprétation, que ce soit par un chef, un instrumentiste ou un ingénieur du son, est une activité créative et risquée selon les degrés de liberté à son niveau d’espace, même si son objet vise la conformité au cadre prédéfini au niveau supérieur.

Gérer l’univers de l’œuvre

Du point de vue de l’auditeur, une œuvre musicale est matériellement délimiteé dans le temps comme un moment bien dissociable et significatif par rapport à l’environnement sonore habituel. Bien que, comme le déclare John Cage, tout environnement sonore puisse être considéré comme musical en tant qu’écoute de la vie elle-même 14[14. Entretien avec John Cage en 1970 (Caux 2009, 41).], ce caractère musical ne peut être effectivement perçu que par une attitude d’écoute à un moment particulier.

Comme le résume la figure 5, l’œuvre déploie ses éléments sur les quatre niveaux d’espace, sur lesquels ils peuvent être travaillés.

Ainsi, au plus haut niveau considéré, l’œuvre est un système voulu et créé par le compositeur pour susciter des relations avec des êtres sonores de ses auditeurs.

Pratique de l’écriture aux différents niveaux

Pour donner un sens large à la notion d’écriture musicale, convenons que tout moyen permettant d’inscrire une représentation de la musique en se libérant de la contrainte du déroulement du temps est un instrument utile.

L’écriture musicale permet donc un changement de topologie, pour transposer le message linéaire auditif dans un espace visuel simultané, et réciproquement. L’écriture permet donc de représenter un système temporel par un système spatial, par mise à plat du temps, et la lecture permet l’inverse, par temporalisation de l’espace.

Lorsqu’on dispose d’une représentation écrite ou enregistrée, il devient alors possible d’accéder très rapidement à toute portion de l’œuvre pour la composer ou l’écouter. Les fonctions correspondantes sont : écrire, éventuellement modifier, et restituer. La création peut ainsi s’appuyer sur l’écriture, en exploitant les fonctions d’inscription et modification sur le support utilisé, et en utilisant la fonction de restitution pour contrôler le résultat.

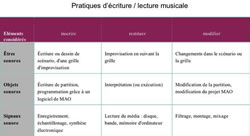

Le tableau suivant (figure 6) présente des exemples de pratiques et artefacts utilisés aujourd’hui pour remplir ces fonctions.

Niveaux d’espace vs courants musicaux

L’analyse par niveaux met aussi en lumière un fait paradoxal : la recherche musicale récente a focalisé principalement ses travaux sur la manipulation des signaux sonores (donc à un niveau proche du phénomène acoustique), et, à l’opposé, la musique traditionnelle et improvisée est directement inspirée par l’évocation d’êtres sonores, comme des sentiments (le « Blues ») ou des thèmes archétypes (donc au niveau le plus abstrait).

Pourquoi ce paradoxe qui renvoie les intellectuels au ras des pâquerettes et les primitifs près du ciel ?

Les apports contemporains de la mondialisation et de la technique ont élargi notre potentiel imaginaire musical, mais le solfège académique s’est révélé réducteur pour tous les objets sonores imaginables.

Pour dépasser cette contrainte, trois directions se présentent naturellement :

- soit redécouvrir l’improvisation, qui met en jeu les être sonores en temps réel;

- soit agir directement au niveau des signaux sonores grâce à des artefacts technologiques;

- soit, enfin, enrichir et élargir le langage du solfège lui-même.

Effectivement, les courants novateurs qui ont marqué le précédent demi-siècle ont exploité des axes de recherche selon ces trois directions :

- la piste free jazz a fait exploser tous les carcans pour revenir, par l’improvisation impulsée directement par le roulis et le tangage complexe des émotions, à une culture radicale affranchie des habitudes mélodiques, harmoniques et rythmiques consciencieusement apprises;

- l’exploration électroacoustique procède par traitement technologique des signaux sonores enregistrés ou synthétiques, pour les assembler en œuvres musicales originales directement sur un support de diffusion;

- l’école en rupture mais héritière de la tradition classique s’intitule « musique contemporaine »; elle complexifie la notation ou invente des systèmes de notation encore plus savants, avec de plus en plus une assistance logicielle.

Le lecteur retrouvera sans peine les grands visionnaires, papes ou gourous qui ont marqué de leur empreinte ces grands courants. Mais, et c’est le lot de toute percée dans l’inconnu, la plupart des auditeurs et des musiciens suivent difficilement. En dehors des rangs de ses fervents, la nouvelle musique est souvent classée comme ésotérique, barbare ou… barbante.

A côté de ces explorateurs, aventuriers ou même chefs de guerre, d’autres musiciens finalement préfèrent garder les mêmes ustensiles pour accommoder l’existant dans de nouvelles mixtures. Ils peuvent faire de mauvaises soupes, mais aussi proposer de nouvelles saveurs, délicates ou fortement épicées, riches ou légères, incorporant aussi bien les influences orientales et africaines que les retombées des découvertes des innovateurs. Néanmoins cette marmite, ce « melting pot », même avec ses compléments électroniques, repose encore sur le substrat bien défini par la musique et les instruments occidentaux conventionnels.

Parmi ces derniers courants, deux sont très illustratifs, quoique à des titres différents :

- les mouvances diverses qui, sous le dénominateur commun de « world music », rassemblent, autour d’une souche jazz rock, instruments, musiciens, chansons de toutes origines; ce courant propose néanmoins des concerts et disques préparés avec précision, dans un grand souci de rigueur professionnelle et de perfection technique;

- le courant « minimaliste », qui, ayant assimilé les êtres sonores nouveaux découverts lors d’expérimentations électroacoustiques, en a épuré (« minimalisé ») les formants, et appliqué ces formants en « lignes claires » 15[15. Je me permets d’emprunter cette notion de « ligne claire » à l’école bruxelloise de bande dessinée, dans la lignée d’Hergé, dont l’art consiste à ne tracer que les lignes à la fois les plus simples et expressives.] pour réaliser des partitions suivant une méthode classique.

Conclusion

N’oublions pas que le premier auditeur d’une pièce élecroacoustique est le compositeur lui-même : ses outils lui offrent un rendu en feedback immédiat de ce qu’il crée, lui permettant de sélectionner ce qui provoque un frémissement positif pour lui-même, dans une sorte de vibration résonnante au niveau de son propre espace musical. Il est ardu de jouer au candide avec soi-même, de se mettre à la place des auditeurs inconnus, de savoir si cette vibration peut les atteindre. Peut-être cet article, qui résume sommairement le trajet chaotique du message musical, peut aider à mettre en œuvre quelques précautions pour augmenter ses chances de parvenir à destination.

Inversement, ne concluons pas impudemment que les contraintes mises en lumière par ce modèle sont inéluctables pour réussir une musique digne d’écoute. Ce serait oublier que la plupart des précurseurs en matière artistique ont outrepassé des limites qu’il était inimaginable de transgresser, et ont ainsi inventé de nouvelles manières de voir et d’écouter.

Bibliographie

Caux, Daniel. Le silence, les couleurs du prisme & la mécanique du temps qui passe. Paris: Editions de l’éclat, 2009, 392pp. ISBN 9782841621972.

Changeux, Jean-Pierre. Raison et plaisir. Paris: Odile Jacob, 1994. 224pp. ISBN 9782738111173.

Moles, Abraham. Théorie de l’information et perception esthétique. Paris: Denoël, 1972. 327pp.

Platel, Charles-Edouard. Musique imaginaire. Paris: Imagimuse, 2007. 145pp. ISBN 9782953011807.

Risset, Jean-Claude. An Introductory Catalogue of Computer Synthesized Sounds. Bell Telephone Laboratories, Murray Hill, New Jersey, 1969.

Schaeffer, Pierre. Traité des objets musicaux. Paris: Seuil, 1966. 720pp. ISBN 2020026082.

Schafer, R. Murray. Tuning of the World. New-York: Knopf, 1977. 301 pp. ISBN 0394409663. Traduction française : Le paysage sonore. Paris: Lattès, 1979.

Vergnon, Laurent. L’audition dans le chaos. Paris: Masson, 2008. 440pp. ISBN 9782294704406.

M.I.M. Nouvelles clés pour l’écoute — Les unités sémiotiques temporelles. CD ROM. Laboratoire Musique et Informatique de Marseilles, 2004. ISBN 2001856016

Social top