Balises perceptuelles

1. Précisions sur l’exportabilité

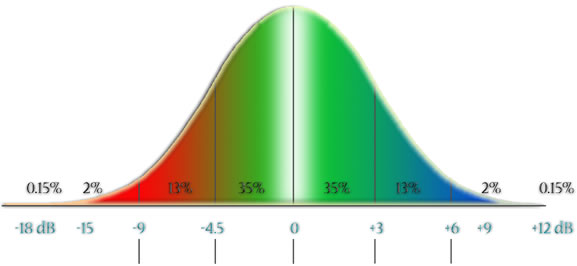

Toute la validité du travail décrit dans les sections précédentes — et des idées développées dans la présente section — repose sur une exportation le plus fidèle possible du résultat du mastering vers le monde extérieur. C’est pourquoi il importe, avant de continuer, de circonscrire avec plus de précision que dans les documents déjà publiés (1) les limites actuelles de cette transposition, sous peine de décevoir des espérances. L’exportabilité du travail de mastering peut être considérée de nos jours comme acquise, mais seulement d’un point de vue statistique : elle n’est jamais une transposition absolue entre le studio de mastering « X » et le système de reproduction de Mr. « Y ». Pour comprendre ce point crucial, il faut examiner la courbe de répartition classique, ici adaptée à la fidélité comparée des systèmes de reproduction maison :

Pour toute région spectrale que l’on veuille considérer, on peut s’attendre à ce que 70 % des systèmes de reproduction se situent dans la fourchette de fidélité raisonnable, de -4,5 dB à +3 dB, qui entoure le zéro de la réponse plate. Cela dit, presque tous les systèmes vont se retrouver, pour un nombre indéterminé de régions spectrales, dans la section des 13 % ou des 2 %, et donc dans une situation de très forte coloration : ces irrégularités dans la réponse en fréquence sont la véritable norme, même pour les systèmes haut de gamme. Seuls les monitorings professionnels installés dans des locaux à l’acoustique contrôlée peuvent prétendre à une réponse située à ±2 dB du centre à toutes les fréquences utiles. Le mastering, qui se fait sur un système semblable, fonctionne donc en vertu d’une loi des moyennes :

- il détecte les anomalies situées dans les régions spectrales pour lesquelles les systèmes utilisés lors du mixage étaient eux-mêmes à l’extérieur de la fourchette normative;

- en compensant pour ces anomalies, il ramène ces régions à l’intérieur de cette fourchette;

- ces compensations, de même que le travail d’amélioration générale de l’euphonie et de la transparence, parviendront avec une fidélité acceptable à 70 % des auditeurs, ou plus précisément parviendront aux auditeurs avec une fidélité acceptable sur 70 % des régions spectrales.

La loi des moyennes, en reproduction maison, comporte aussi quelques corollaires qui se traduisent par des limitations supplémentaires qu’il n’est pas inutile de mentionner :

- une proportion importante du 30 % des régions spectrales ne passant pas le test de l’exportabilité se concentre dans les basses fréquences, là où on retrouve, pour la plupart des locaux non traités, les problèmes acoustiques les plus graves;

- cette limitation est encore accentuée dès qu’on touche aux sous-graves, très facilement affectées par des subwoofers — quand ils existent — typiquement réglés trop fort, pour convenir aux besoins du cinéma maison, ou pas assez, par crainte de déranger les voisins;

- c’est aussi dans ces fréquences qu’on pourra éprouver les conséquences du manque de réserve de puissance des mini chaînes, haut-parleurs satellites pour ordinateurs et autres iPods : certaines incursions plein volume à moins de 50 Hz peuvent provoquer de la distorsion dans ces systèmes. Filtrer ces fréquences pour accommoder les amplificateurs de 25 W et moins revient à pénaliser l’écoute sur les systèmes plus performants. Il n’y a pas de solution autre que de faire des compromis, dans un sens ou dans l’autre;

- même en l’absence de discontinuités au niveau de la réponse en fréquence, le manque de réserve peut affecter la clarté dans les passages pleine bande comportant de nombreuses couches simultanées. Ce sont des contextes où même la transparence introduite par le mastering ne peut être reproduite par un équipement de reproduction aux performances trop médiocres.

L’autre limite de cette universalité de l’exportation n’est pas statistique, mais est associée à certains contenus. Que se passe-t-il donc dans le cas d’une esthétique basée sur des ambiguïtés, inconforts ou agressions d’ordre purement physique durant l’audition ? Le mot physique est ici important, puisque la question doit naturellement exclure toutes les expériences musicales qui suggèrent l’ambiguïté, l’inconfort ou l’agression par des signifiants esthétiques, expériences relevant toujours du domaine de l’euphonie. Dans les cas, donc, où la tentative est bel et bien de l’ordre d’une utilisation directe, concrète et majoritaire de propriétés audio dérangeantes (frictions fréquentielles, distorsions intermodulaires, effets basés sur des différences de phase entre les canaux de reproduction, etc.) l’expérience démontre que l’exportabilité ne fonctionne à peu près pas. Il semble que le cerveau soit en mesure de décoder — sauf dans les cas les plus extrêmes de fluctuation de réponse en fréquence — la plupart des propositions euphoniques correctement masterisées, et ce même à travers un voile raisonnable de colorations et distorsions. Mais il ne réussit pas à faire la même opération pour les programmes basés sur des inconforts physiques précis, qui demeureront donc pour le moment très étroitement dépendants d’une haute précision d’exportation, irréalisable pour l’immense majorité des auditeurs. Pour ces programmes, le mastering ne sera d’aucune utilité : les effets d’inconfort prévus seront vraisemblablement perçus, par l’ingénieur de mastering, de manière biaisée par rapport à l’intention de mixage, et seraient-ils perçus correctement que les corrections visant ces effets — ainsi que les effets eux-mêmes — ne parviendraient pas à l’auditeur.

2. Le principe de l’euphonie

Le mastering est donc limité à une esthétique d’euphonie. D’un point de vue audio, cette esthétique est définie par la recherche d’un chemin d’accès vers le contenu musical qui soit le plus transparent possible, et donc débarrassé du maximum d’agressions physiques directes à l’auditeur et du maximum d’ambiguïtés (au niveau de la nature de l’objet sonore, de sa localisation, etc.) étrangères à l’intention esthétique de départ du compositeur. On a vu que le compositeur, dans son travail de production, peut être lui-même responsable, sans le savoir, d’une majorité de ces agressions et ambiguïtés. Ajoutons que, la télépathie n’étant pas encore tout à fait au point, la remise à jour du contenu esthétique original qu’est le mastering ne peut être parfaitement infaillible : il n’est pas exclu que certaines manipulations produisent des résultats qui soient jusqu’à un certain point parallèles plutôt qu’identiques à l’intention de base, ni même que quelques corrections puissent à l’occasion mettre le contenu mieux en valeur que ne l’avait prévu le compositeur, ce qui n’a provoqué aucune protestation de leur part à ce jour…

Le but de cet article est de suggérer que ces déviations resteront limitées en nombre et en importance, par l’action permanente d’un certain nombre de critères, que nous avons baptisés « balises perceptuelles », et qui guideront le travail du mastering, rendant ses résultats relativement prédictibles et fiables. Dans la limite du concept d’euphonie, ces balises ont une certaine valeur objective en ce qu’elles sont justement perceptuelles, et non sémantiques, analytiques ou structurelles. Et c’est en ce sens que la dynamique artistique de la pièce masterisée demeurera essentiellement intacte, alors même que le chemin vers cette dynamique aura été largement déblayé.

3. Préférences spectrales

Près de quarante ans de mastering en musique commerciale ont montré que, dès que les agressions sonores et les ambiguïtés majeures sont supprimées, l’auditeur est laissé devant la musique beaucoup plus disponible, moins sollicité par des signaux d’alarme en provenance de ses différents systèmes de protection. Cette nouvelle disponibilité s’accompagne déjà, en général, d’une mise au jour de détails ou de couches sonores jusqu’ici masqués par les phénomènes perturbateurs.

La réticence habituellement exprimée ici est la suivante : comment l’ingénieur de mastering parvient-il à isoler et à corriger à coup sûr les seuls phénomènes perturbateurs, sans mettre en jeu ses propres préférences culturelles et spectrales ? La réponse est simple : pareil biais dans la correction ne fonctionnerait tout simplement pas ! On a beau détester cordialement la fréquence 250 Hz, se permettre de la filtrer arbitrairement dans un programme dont le boursouflement dans les basses se situerait en réalité à 160 Hz ne ferait que cacher les détails centrés autour de 250 Hz, qui étaient auparavant correctement équilibrés. Même si l’ingénieur était d’une totale mauvaise foi, et qu’il décidait d’imposer la coupure coûte que coûte, le compositeur, lui, ne manquerait pas de questionner la perte de ces détails. D’autant plus qu’il sera difficile de corriger également à 160 Hz, sous peine de se retrouver avec des hautes basses grossièrement amputées. En bout de ligne, l’album sonnerait mal, récolterait des critiques négatives, et la réputation de l’ingénieur en souffrirait.

Cette réponse vaut également pour les inquiétudes, exprimées par quelques compositeurs, concernant l’aptitude qu’aurait le mastering à conférer systématiquement aux œuvres un profil spectral uniforme, obéissant par exemple à une tendance éphémère. Cela est possible en pop, et encore faut-il que les sources « de la saison » soient présentes dans le programme, mais en électroacoustique, la disparité des matériaux en présence rend très improbable ce type de modélisation : même si un gourou de l’audio décrétait qu’il faut que la fréquence 400 Hz soit prédominante ce printemps, il est tout à fait envisageable qu’il n’y ait absolument rien, dans une œuvre donnée, à aller chercher à cette fréquence !

4. La perception pré esthétique

Maintenant que nous avons défini tout ce qui est en dehors des limites de son pouvoir, nous pouvons enfin tenter d’expliquer comment l’ingénieur de mastering peut effectivement faire ce qu’il fait : détecter à coup sûr les incongruités et les corriger de manière efficace. L’explication pourra paraître soit décevante, soit d’une simplicité rassurante : il se concentre sur des phénomènes relevant de la perception pré esthétique, signalisés et interprétés selon un fonds instinctuel commun, et déclenchant des réactions associatives préétablies de défense, de rejet, de plaisir, d’excitation, etc. Le mot instinctuel pourrait-il être remplacé ici par génétique ? Ne devrait-on pas plutôt invoquer les archétypes ? Aux fins du mastering, ces questions sont probablement accessoires : d’autres pourront se charger de trancher. Quoi qu’il en soit, pour être précise, c’est-à-dire pour qu’elle demeure circonscrite au domaine pré esthétique, la détection de ces phénomènes doit évidemment être faite par quelqu’un qui possède déjà une expérience étendue des possibilités esthétiques du genre musical à masteriser.

Précisons que les balises perceptuelles présentées ici ne sont rien de plus qu’une tentative d’illustration de mécanismes pratiques, utilisés dans le cadre d’une technique précise. On peut les concevoir en tant que collection d’outils, liste de vérification, aide à la tâche, tout ce qu’on voudra sauf une théorie générale de la correction audio.

Bien que non exhaustive, la liste de ces phénomènes est déjà assez longue : une classification sommaire servira à la départager en balises de rejet et en balises positives. Une session de mastering débute en général par la détection et la correction des problèmes les plus criants. S’il reste du temps — une autre limitation, hélas courante — on pourra porter son attention sur les problèmes plus subtils, avant de passer à l’étape d’optimisation de l’euphonie. C’est dans cet ordre que se fera la présentation des balises perceptuelles.

4.1 Balises de rejet

Les balises de rejet sont à comprendre comme des cloches d’alarme, signalant un problème à l’attention de l’ingénieur de mastering. Il reviendra à ce dernier d’évaluer s’il est possible et souhaitable d’intervenir, en usant de quels procédés et avec quelles éventuelles conséquences :

- un son fortement résonant est indicateur d’un espace confiné, potentiellement étouffant;

- les réverbérations courtes ou fortement colorées, sont également associées aux espaces confinés : il est piquant de constater que les machines et logiciels qui produisent ce type de réverbérations sont généralement considérés comme étant bas-de-gamme;

- les résonances et boursouflements dans les basses fréquences — la fameuse boominess — sont des signaux de crises majeures : tremblements de terre, éruptions volcaniques, attaques de fauves, etc. L’angoisse ressentie est-elle en accord avec le contenu ?

- la localisation imprécise ou ambiguë d’une source est génératrice de tension, ou tout au moins d’interrogations instinctives qui peuvent ne pas être en phase avec l’intention esthétique du passage musical;

- de même, la confusion des plans évoque les situations hors de contrôle, les dangers cachés, les charges effrénées;

- la distorsion est aussi associée aux situations de crise : attaques, hurlements, appels d’urgence, foules en colère;

- les courbes dynamiques erratiques ou imprévisibles sont une potentialité accrue de dommages pour l’appareil auditif. Un réflexe de fermeture s’ensuit, lequel diminue la précision auditive;

- les fréquences aiguës émises de façon éraillée et discontinue sont évocatrices d’étouffement, de maladie, voire d’agonie;

- la tension dans la voix humaine est facilement discernable : cassures dans la courbe dynamique, déplacement vers le haut du profil formantique et amincissement général. Les voix tendues jugulent les écarts de dynamique par des resserrements de gorge amincissant la courbe fréquentielle : le parallèle avec les problèmes généralement liés aux compresseurs pleine bande est ici saisissant. Les mêmes caractéristiques peuvent être identifiées dans un événement audio de nature non vocale et provoquer les mêmes malaises.

On pourra objecter avec raison que ces manifestations peuvent parfaitement être délibérées de la part du compositeur, auquel cas les corriger systématiquement porterait un préjudice irréparable à la signification de l’œuvre. C’est ici qu’intervient la notion d’ambiguïté sémantique entre le message latent d’un objet sonore et sa manifestation réelle : ces manifestations parviennent-elles à l’oreille de manière non équivoque, en accord ou tout au moins en relation claire avec le contenu ? Peut-on déceler de la distorsion, un problème de phase, une coloration suspecte qui soufflerait à l’ingénieur de mastering que « quelque chose ne va pas » ? Qu’on est peut-être ici en présence d’un autre cas d’exportation manquée pour raison technique ?

Un exemple très schématisé serait l’apparition, au moment le plus calme d’une section évoquant une grande distance, d’un son x affecté d’une bosse résonante indicatrice de proximité. Même si la résonance n’est pas agressante en soi et que la sensation de proximité est précise, l’ingénieur de mastering soupçonnera un problème et commencera à chercher : si le phénomène était volontaire, cela pourrait être confirmé par la présence, ailleurs dans la même pièce, d’un son y, en tout point identique à x mais sans la bosse résonante. D’autres indices — perceptifs ou stylistiques — pourraient venir confirmer cette interprétation, éliminant ainsi la possibilité d’une erreur. Une ambiguïté volontaire devrait, en vertu du talent d’expression en principe rattaché au titre de compositeur, être manifeste : un signifiant musical n’est-il pas le plus souvent annoncé, accompagné ou confirmé par d’autres signes stylistiques ?

Mais il est aussi possible que l’ambiguïté ait été masquée aux oreilles du compositeur par une déficience de son système d’écoute. Cette déficience pourrait être confirmée par la réapparition systématique — et dans d’autres contextes — de la même bosse résonante pour plusieurs objets sonores de la même région fréquentielle.

Quand, rarement, il advient que les indices soient absents ou contradictoires, il reste encore la possibilité de tester une ou plusieurs interprétations en faisant des corrections tentatives : une de ces corrections fournira peut-être un résultat se démarquant nettement des autres tentatives, éclairant soudain tout le contexte musical ! Si cette dernière démarche se révèle non concluante, l’ingénieur de mastering ne prendra pas le risque de modifier l’objet sonore.

4.2 Balises positives

Cet ensemble d’indicateurs peut agir de deux façons. Ils peuvent d’abord être des points d’arrivée anticipés pour une correction suggérée par la détection d’une balise de rejet. Ils servent aussi, dans ce contexte, à s’assurer que la correction a bel et bien fonctionné. Mais leur action peut être également complètement indépendante des balises de rejet : il permettent alors de détecter une sensation positive, en germe ou même déjà perceptible, mais qu’il pourrait être intéressant de renforcer. Ce second type d’action ne mène pas nécessairement à des résultats plus étrangers à l’intention du compositeur que les actions correctrices : certains outils disponibles au mastering peuvent être inaccessibles aux compositeurs, et offrir un niveau de qualité et d’efficacité dont ils auraient souhaité bénéficier — on peut penser ici aux réverbérations haut-de-gamme et aux élargisseurs stéréo. Dans d’autres cas, ce sont les limites du système d’écoute du compositeur qui auront freiné sa recherche d’euphonie : il se sera alors résigné à un certain niveau de qualité, alors même que le contenu audio recelait encore des potentialités d’expansion.

- une image stéréo très large, composée de sons non colorés, génère une sensation d’espaces extérieurs, de situation en hauteur : transcendance, contrôle, mais aussi liberté, aventure et découverte;

- une source précisément localisée est sécurisante : elle est aussi plus susceptible de transmettre son message esthétique propre; les plans multiples ont d’autant plus besoin de transparence et de différenciation au niveau de leur localisation et de la détermination aisée de leur nature;

- un son extrêmement proche est, par nature, non coloré; correctement localisé, il génère un sentiment d’intimité rassurante. C’est une situation d’extrêmes dynamiques, potentielles mais non utilisées, dans laquelle les transitoires sont le mieux perçues;

- certaines formes de résonances contrôlées, dans le bas médium, pourraient évoquer une gamme de nuances reliées au sentiment de sécurité, telles que vécues, par exemple, par le fœtus;

- l’attrait pour les extrêmes aiguës — à condition que leur flux d’émission soit souple et régulier — est à associer au contenu fréquentiel des sons émis par les bébés gazouillant et par les adultes durant les relations sexuelles : murmures, soupirs, etc.

- les courbes dynamiques douces envoient un message de sécurité à l’appareil auditif, lequel, n’ayant plus de raison de se protéger, augmente sa sensibilité;

- une voix réputée agréable présente des caractéristiques audio identifiables : aussi dites ouvertes, ces voix offrent un contenu fréquentiel plus étendu, mieux réparti, avec une présence discrète mais notable des extrêmes aiguës. Le contenu fréquentiel est tel qu’elles sont clairement perçues, sans addition apparente d’énergie. Le flux dynamique est régulier et ne semble pas nécessiter de contrôle. Comme pour les voix tendues de la section précédente, toutes ces caractéristiques sont facilement transposables aux sonorités non vocales, qui pourront ainsi générer des réactions semblables.

Une confirmation intéressante de l’influence des balises positives se trouve dans l’attrait — que dis-je, dans l’obsession hypnotique — pour la compression dynamique en production commerciale, qui permet de combiner deux d’entre ces balises, en principe incompatibles, en un tout euphorisant. D’une part, une dynamique limitée, sécurisante pour l’oreille en tant que telle, mais aussi par confirmation de l’éloignement de la source d’agression. D’autre part, l’effet de proximité des transitoires mises en valeur durant le temps d’attaque. On obtient ainsi une fausse sensation de danger, apportée par la forte dynamique des transitoires, immédiatement contredite par la baisse qui survient après avoir le temps d’attaque. C’est un plaisir de style Luna Park : le frisson de l’aventure dans une situation parfaitement contrôlée…

5. Les mécanismes d’identification de la qualité audio

L’idée maîtresse est donc que la réceptivité envers l’œuvre est portée à son maximum par des conditions de perception optimalisées au niveau de l’instinct. Cette transparence est obtenue lorsque tous les signaux d’alarme émis par les balises de rejet se sont tus, à l’exception de ceux qui sont en accord avec le contenu, et que les propositions esthétiques suggérées par le programme lui-même sont pleinement soutenues par les balises positives appropriées.

Il serait évidemment facile d’invoquer, à l’appui de cette notion de réceptivité, les expériences contemporaines, menées en particulier dans le domaine du eLearning, et témoignant de facilités d’apprentissage accrues avec l’utilisation d’objets visuels ou sonores de haute définition. Mais ce serait également injuste, en ce sens que ces recherches — on peut aussi invoquer les résultats obtenus en psychologie de la perception — se contentent d’enregistrer des différences de réaction face à des objets déjà existants, alors que le mastering doit s’inventer l’intégralité de la mécanique permettant la transformation d’objets sonores de basse ou moyenne résolution en objets de haute résolution. Si aucune « preuve » scientifique n’a été évoquée, même de loin, tout au long de cette publication, c’est que les ingénieurs de mastering ne peuvent se payer le luxe d’attendre que ces différentes recherches aboutissent à quoi que ce soit d’utilisable sur le plan pratique, ne serait-ce qu’une simple définition, sur laquelle tout le monde s’entende, de ce qu’est la qualité audio.

5.1 Le vocabulaire audiophile

Or, les idées développées dans cet article tendent à montrer que les mécanismes d’identification de la qualité audio ne sont obscurs qu’en apparence : ils sont toujours liés à une perception la plus transparente possible du contenu. Il faut évidemment être en mesure d’identifier cette transparence, et les malentendus provoqués par la prolifération des écoutes biaisées ont été tels qu’il s’est développé, à l’usage des « audiophiles », tout un vocabulaire descriptif, aussi abscons que pédant. De là à en déduire que la qualité audio elle-même était essentiellement subjective, il n’y a eu qu’un pas, et ce pas a été franchi par l’immense majorité non seulement des auditeurs non audiophiles, mais aussi des personnes travaillant dans tous les domaines de l’audio.

Cette modestie des professionnels est tout de même surprenante, compte tenu du fait qu’une proportion souvent considérable de leurs compétences est liée à une capacité immédiate, répétable et confirmable par les pairs, de reconnaître la qualité audio. Par ailleurs, les immenses progrès réalisés tant au niveau de l’équipement que des produits musicaux eux-mêmes prouvent qu’il y a des gens, quelque part, qui savent tout de même ce qu’ils font ! On peut risquer quelques explications à propos de cet étrange et presque universel auto déni de compétence, qui se traduit par une véritable réticence des professionnels à analyser et à rendre compte, sur le plan de l’écrit, d’une pratique pourtant quotidienne :

- la volonté de se distancier de la préciosité audiophile;

- le fait que plus grande est la transparence, plus l’effort de production s’efface, par définition, devant le contenu. Pour juger de la qualité audio d’un produit transparent, il faut être en mesure de parler du contenu audio lui-même. Un discours d’une tout autre nature est à produire : là où il lui suffisait autrefois de rapporter un excédent de basses fréquences ou un bruit de fond trop présent, le critique de qualité audio contemporain devient confronté à l’immense variété des contenus, variété devant laquelle n’importe quelle érudition musicale ne pourrait que baisser les bras. S’il est encore possible d’identifier les grandes tendances en instrumentation classique, la prolifération des équipements et procédés en production commerciale moderne est une toute autre affaire : marques, modèles, microphones, préamplificateurs, studios, ingénieurs, réalisateurs, processeurs, logiciels, gravure, pressage, tout cela peut avoir une influence sur la sonorité finale du produit, et il peut être extrêmement difficile d’en rendre compte de façon synthétique et pertinente. Beaucoup de généralisations, bafouillages et improvisations résultent de ce changement;

- la reconnaissance précise des points de départ des sources, l’interprétation des résonances et de la plupart des autres balises perceptuelles, tout cela se produit dans le domaine instinctuel, et sans aucun appui scientifique. Dans ces conditions, peu de professionnels prendront le risque d’exposer clairement leurs idées personnelles sur cet aspect primordial de leur propre pratique. D’autant plus étrange que les séances de travail et d’écoute critique entre ces mêmes professionnels sont en général très actives sur le plan verbal, et que l’unanimité des perceptions est presque systématique…

5.2 La transparence en électroacoustique

L’absence d’un discours descriptif crédible, la confusion due aux systèmes d’écoute, les réticences qui s’ensuivent, rien de cela ne semble affecter la clandestine unanimité des professionnels sur la nature de la qualité audio, et sur son lien avec la transparence. Qualité et transparence qui semblent être à coup sûr détectables par ce groupe sur une simple écoute, sans la moindre renseignement sur la nature des sources ou sur les conditions de production. Une mécanique précise est forcément à l’œuvre ici, et cette précision même élimine d’emblée l’entrée en jeu d’une quelconque analyse structurelle, culturelle ou sémantique.

Mais les balises perceptuelles, qui sont notre explication temporaire, peuvent-elles fonctionner dans le cas des musiques produites dans des cadres ou avec des moyens non naturels ? La reconnaissance de la transparence est-elle encore possible lorsque les espaces, les contenus spectraux et les timbres eux-mêmes sont lourdement métamorphosés ou même entièrement artificiels ? On pense immédiatement à l’électroacoustique, mais aussi à toutes les productions usant à des degrés divers de la synthèse et des transformations. Or, très curieusement, on constate que tant les aises que les malaises sont de même nature, et aussi faciles à identifier, que dans les productions de captation. Il semblerait que l’univers des sons inouïs soit aussi un univers tridimensionnel, et que sa transposition sur support ait à répondre aux mêmes critères de spatialisation, d’euphonie, puisqu’il déclenche avec tout autant de force l’entière batterie des balises perceptuelles.

Le mastering de ces productions utilisera donc extensivement, sur le même mode pré esthétique que pour tous les autres genres musicaux, les messages provenant de ces balises, positives et de rejet, pour décider de la marche à suivre dans chaque contexte bien précis. Et cette précision peut fort bien se traduire, en électroacoustique, à un passage de quelques secondes, ou, dans les cas de livraison en stems, à chacune des composantes internes de ce passage. On comprendra qu’avec un tel degré de focalisation, l’esthétique globale du compositeur est loin d’être en question.

Mode d’analyse pré esthétique, balises perceptuelles, localisation pointue des problèmes et des correctifs, toutes ces notions sont encore au niveau tentatif et demanderont à être affinées avec la pratique. Une pratique qui ne pourra elle-même se développer que dans la mesure où les compositeurs cesseront de considérer leur auditoire actuel, minuscule mais tolérant au niveau de la qualité audio, comme seul horizon. Un public plus vaste les attend, avide d’espaces nouveaux, mais il faut savoir que ce public, déjà de plus en plus exposé à la transparence dans d’autres genres musicaux, n’aura aucune raison d’accepter des malaises et des aggressions sonores d’un autre âge, et que le mastering ne peut que partiellement corriger. Il exigera de l’électroacoustique qu’elle prenne les moyens de produire sa propre version de la transparence, de manière à ce qu’il puisse s’évader, explorer et découvrir sans entraves. La survie du genre est à ce prix.

Références

- Voir Dominique Bassal, “La pratique du mastering en électroacoustique,” eContact! 6.3 — Questions en électroacoustique / Issues in Electroacoustics (2003), pp. 49–50, section 2.3.4.

Social top